“텍스트만으로는 부족해.”

2024년까지만 해도 AI에게 무언가를 설명하려면 장황한 텍스트가 필요했습니다. 스크린샷 하나면 끝날 일을 수백 단어로 풀어써야 했죠. 하지만 2025년, 멀티모달 AI의 등장으로 상황이 완전히 바뀌었습니다. 이제 이미지를 보여주고, 음성으로 질문하고, 영상을 분석하는 것이 자연스러운 일상이 되었습니다.

딜로이트의 ‘2025 AI 트렌드’ 보고서에 따르면, 멀티모달 AI는 올해 기업들이 가장 주목하는 기술 중 하나입니다. 이 글에서는 멀티모달 AI의 핵심 개념부터 실제 개발에 적용하는 방법까지, 한국어로 제대로 정리해드리겠습니다.

멀티모달 AI란? 핵심 개념 이해하기

멀티모달(Multimodal)이란 여러 종류의 데이터 형태(모달리티)를 동시에 처리하는 것을 의미합니다. 인간이 눈으로 보고, 귀로 듣고, 손으로 만지며 세상을 이해하듯, 멀티모달 AI도 다양한 입력을 통합하여 더 깊은 이해를 구현합니다.

모달리티의 종류

| 모달리티 | 설명 | 예시 |

|---|---|---|

| 텍스트 | 자연어, 코드, 문서 | 채팅, 번역, 요약 |

| 이미지 | 사진, 그래프, 다이어그램 | OCR, 이미지 분석 |

| 오디오 | 음성, 음악, 환경음 | 음성 인식, 감정 분석 |

| 비디오 | 영상 시퀀스 | 행동 인식, 요약 |

기존의 단일 모달 AI는 각 영역에서 뛰어났지만, 현실 세계의 복잡한 문제를 해결하기에는 한계가 있었습니다. 예를 들어, 의료 분야에서 환자의 MRI 이미지(시각)와 의료 기록(텍스트), 의사의 음성 메모(오디오)를 종합적으로 분석해야 정확한 진단이 가능합니다.

# 단일 모달 vs 멀티모달 접근 비교

# 단일 모달: 텍스트만 처리

response = client.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": "이 증상에 대해 설명해줘"}]

)

# 멀티모달: 이미지 + 텍스트 동시 처리

response = client.chat.completions.create(

model="gpt-4-vision-preview",

messages=[{

"role": "user",

"content": [

{"type": "text", "text": "이 X-ray 이미지에서 이상 소견을 찾아줘"},

{"type": "image_url", "image_url": {"url": image_base64}}

]

}]

)

주요 멀티모달 모델 비교: GPT-4V vs Gemini vs Claude

2025년 현재, 실전에서 사용할 수 있는 멀티모달 모델은 크게 세 가지입니다. 각각의 특성을 이해하고 상황에 맞게 선택하는 것이 중요합니다.

| 특성 | GPT-4V (OpenAI) | Gemini 1.5 Pro (Google) | Claude 3.5 Sonnet (Anthropic) |

|---|---|---|---|

| 이미지 이해 | ★★★★★ | ★★★★☆ | ★★★★★ |

| 비디오 분석 | ❌ | ★★★★★ (네이티브) | ❌ |

| 컨텍스트 길이 | 128K | 1M (!) | 200K |

| 코드 생성 | ★★★★☆ | ★★★★☆ | ★★★★★ |

| 가격 (1M 토큰) | $10 | $7 | $3 |

| API 안정성 | ★★★★★ | ★★★★☆ | ★★★★★ |

GPT-4V: 범용성의 왕

OpenAI의 GPT-4V(Vision)는 가장 널리 사용되는 멀티모달 모델입니다. 특히 이미지 내 텍스트 인식(OCR)과 차트/그래프 해석에서 뛰어난 성능을 보입니다.

Gemini 1.5 Pro: 컨텍스트의 제왕

Google의 Gemini는 100만 토큰 컨텍스트 윈도우라는 압도적인 장점을 가집니다. 1시간짜리 영상을 통째로 분석하거나, 수천 페이지의 문서를 한 번에 처리할 수 있습니다.

Claude 3.5 Sonnet: 코딩 특화

Anthropic의 Claude는 코드 이해와 생성에서 두각을 나타냅니다. 스크린샷만 보여줘도 해당 UI를 구현하는 코드를 생성하는 능력이 탁월합니다.

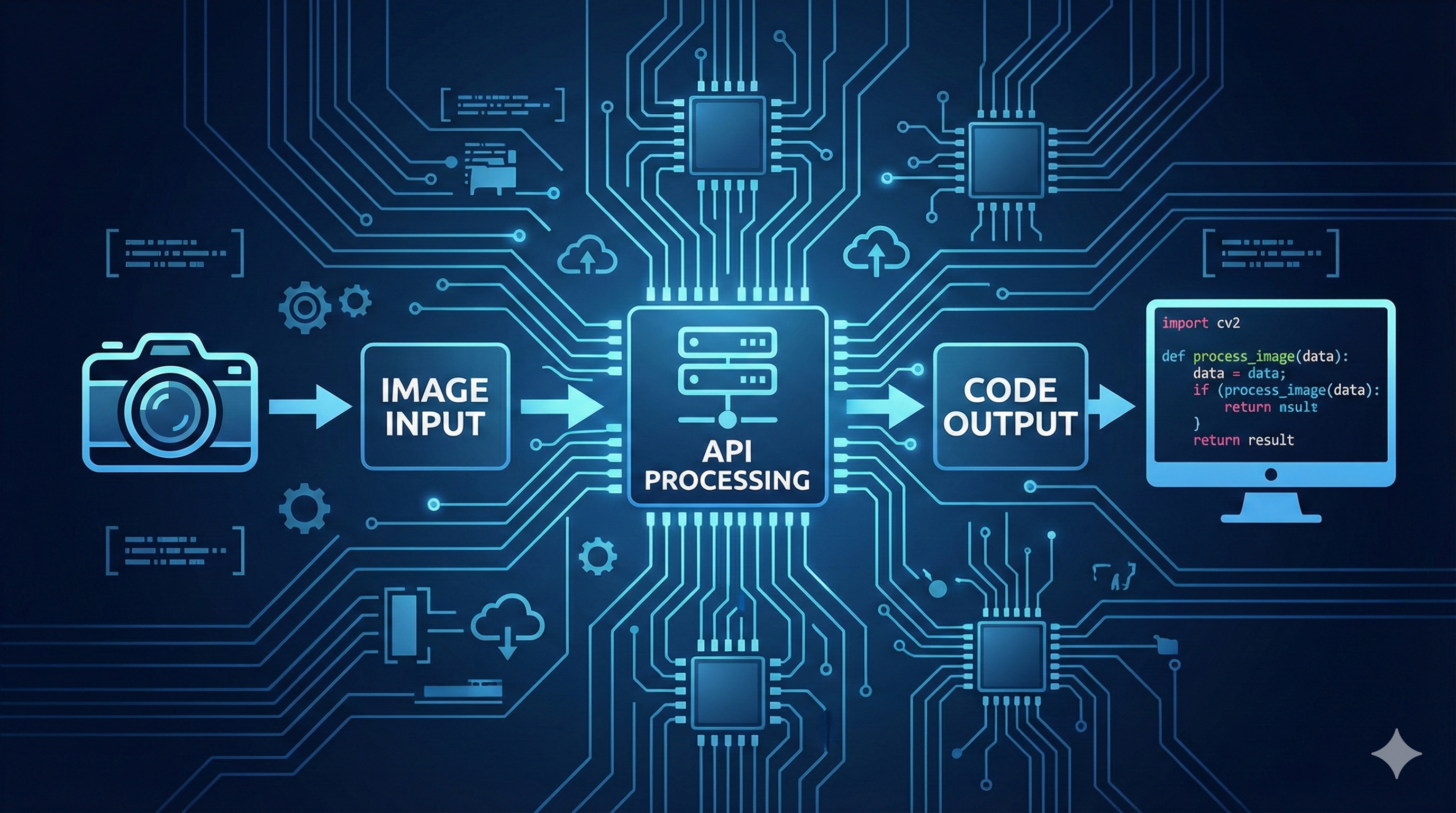

실전 활용: Python으로 멀티모달 API 연동하기

이론은 충분합니다. 이제 실제로 코드를 작성해봅시다. 가장 흔한 유스케이스인 “이미지 분석 + 텍스트 응답”을 구현해보겠습니다.

1. OpenAI GPT-4V 활용

import openai

import base64

from pathlib import Path

def encode_image(image_path: str) -> str:

"""이미지를 base64로 인코딩"""

with open(image_path, "rb") as image_file:

return base64.b64encode(image_file.read()).decode("utf-8")

def analyze_image_with_gpt4v(image_path: str, prompt: str) -> str:

"""GPT-4V로 이미지 분석"""

client = openai.OpenAI()

base64_image = encode_image(image_path)

response = client.chat.completions.create(

model="gpt-4-vision-preview",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": prompt},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}",

"detail": "high" # low, high, auto

}

}

]

}

],

max_tokens=1000

)

return response.choices[0].message.content

# 사용 예시

result = analyze_image_with_gpt4v(

"screenshot.png",

"이 UI 스크린샷을 분석하고, UX 개선점을 3가지 제안해줘"

)

print(result)

2. Google Gemini 활용

import google.generativeai as genai

from PIL import Image

def analyze_with_gemini(image_path: str, prompt: str) -> str:

"""Gemini로 이미지 분석"""

genai.configure(api_key="YOUR_API_KEY")

model = genai.GenerativeModel("gemini-1.5-pro")

image = Image.open(image_path)

response = model.generate_content([prompt, image])

return response.text

# 영상 분석 (Gemini 고유 기능)

def analyze_video_with_gemini(video_path: str, prompt: str) -> str:

"""Gemini로 영상 분석 - 1M 토큰 컨텍스트 활용"""

genai.configure(api_key="YOUR_API_KEY")

model = genai.GenerativeModel("gemini-1.5-pro")

# 영상 업로드 (최대 1시간 분량)

video_file = genai.upload_file(video_path)

response = model.generate_content([prompt, video_file])

return response.text

# 사용 예시: 1시간짜리 회의 영상 요약

summary = analyze_video_with_gemini(

"meeting_recording.mp4",

"이 회의에서 논의된 주요 안건과 결정 사항을 요약해줘"

)

3. Anthropic Claude 3.5 활용

import anthropic

import base64

def analyze_with_claude(image_path: str, prompt: str) -> str:

"""Claude 3.5 Sonnet으로 이미지 분석"""

client = anthropic.Anthropic()

with open(image_path, "rb") as f:

image_data = base64.b64encode(f.read()).decode("utf-8")

# 확장자로 media_type 결정

media_type = "image/png" if image_path.endswith(".png") else "image/jpeg"

response = client.messages.create(

model="claude-3-5-sonnet-20241022",

max_tokens=1024,

messages=[

{

"role": "user",

"content": [

{

"type": "image",

"source": {

"type": "base64",

"media_type": media_type,

"data": image_data

}

},

{

"type": "text",

"text": prompt

}

]

}

]

)

return response.content[0].text

# 사용 예시: UI 스크린샷 → 코드 생성

code = analyze_with_claude(

"figma_design.png",

"이 디자인을 React + Tailwind CSS로 구현하는 코드를 작성해줘"

)

print(code)

개발자가 알아야 할 5가지 실전 팁

1. 이미지 전처리로 비용 절감

멀티모달 API는 이미지 크기에 따라 토큰을 소비합니다. 불필요하게 큰 이미지는 비용만 늘릴 뿐입니다.

from PIL import Image

def optimize_image_for_api(image_path: str, max_size: int = 1024) -> str:

"""API 호출 전 이미지 최적화"""

img = Image.open(image_path)

# 비율 유지하며 리사이즈

if max(img.size) > max_size:

ratio = max_size / max(img.size)

new_size = tuple(int(dim * ratio) for dim in img.size)

img = img.resize(new_size, Image.LANCZOS)

# WebP로 변환 (용량 50% 감소)

optimized_path = image_path.rsplit(".", 1)[0] + "_optimized.webp"

img.save(optimized_path, "WEBP", quality=85)

return optimized_path

2. 프롬프트에 구체적인 출력 형식 명시

# Bad: 모호한 프롬프트

prompt = "이 이미지를 분석해줘"

# Good: 구조화된 출력 요청

prompt = """

이 UI 스크린샷을 분석하고 다음 JSON 형식으로 응답해줘:

{

"components": ["발견된 UI 컴포넌트 목록"],

"color_palette": ["사용된 주요 색상 HEX 코드"],

"accessibility_issues": ["접근성 문제점"],

"improvement_suggestions": ["개선 제안 3가지"]

}

"""

3. 비용 모니터링 자동화

import tiktoken

def estimate_vision_cost(image_path: str, prompt: str) -> dict:

"""멀티모달 API 호출 비용 추정"""

# 텍스트 토큰

enc = tiktoken.encoding_for_model("gpt-4")

text_tokens = len(enc.encode(prompt))

# 이미지 토큰 (GPT-4V 기준, high detail)

img = Image.open(image_path)

width, height = img.size

# 512x512 타일 단위로 계산

tiles = ((width // 512) + 1) * ((height // 512) + 1)

image_tokens = 85 + (170 * tiles) # base + per-tile

total_tokens = text_tokens + image_tokens

cost = (total_tokens / 1000) * 0.01 # $0.01 per 1K tokens

return {

"text_tokens": text_tokens,

"image_tokens": image_tokens,

"total_tokens": total_tokens,

"estimated_cost_usd": round(cost, 4)

}

4. 에러 핸들링 필수

import time

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=4, max=10))

def safe_vision_call(image_path: str, prompt: str):

"""재시도 로직이 포함된 안전한 API 호출"""

try:

return analyze_image_with_gpt4v(image_path, prompt)

except openai.RateLimitError:

print("Rate limit hit, waiting...")

time.sleep(60)

raise

except openai.BadRequestError as e:

if "image" in str(e).lower():

print("Invalid image format")

return None

raise

5. 캐싱으로 중복 호출 방지

import hashlib

import json

from pathlib import Path

CACHE_DIR = Path(".vision_cache")

CACHE_DIR.mkdir(exist_ok=True)

def cached_vision_call(image_path: str, prompt: str):

"""이미지+프롬프트 해시로 캐싱"""

# 캐시 키 생성

with open(image_path, "rb") as f:

image_hash = hashlib.md5(f.read()).hexdigest()

prompt_hash = hashlib.md5(prompt.encode()).hexdigest()

cache_key = f"{image_hash}_{prompt_hash}"

cache_file = CACHE_DIR / f"{cache_key}.json"

# 캐시 히트

if cache_file.exists():

return json.loads(cache_file.read_text())

# API 호출 및 캐시 저장

result = analyze_image_with_gpt4v(image_path, prompt)

cache_file.write_text(json.dumps({"result": result}))

return {"result": result}

마치며: 멀티모달 AI의 미래

멀티모달 AI는 더 이상 실험실의 기술이 아닙니다. 이미 고객 서비스(이미지로 문의), 교육(영상 강의 요약), 의료(영상 진단 보조), 개발(스크린샷 → 코드) 등 다양한 분야에서 실전 투입되고 있습니다.

2026년에는 실시간 비디오 스트림 분석, 3D 공간 이해, 촉각/후각 데이터 통합까지 확장될 전망입니다. 지금 멀티모달 AI의 기초를 익혀두면, 곧 다가올 더 큰 변화에도 유연하게 대응할 수 있을 것입니다.

여러분의 다음 프로젝트에 멀티모달 AI를 한번 적용해보세요. 텍스트만으로는 불가능했던 새로운 가능성이 열릴 것입니다.

참고 자료: