2월 11일, 개발자들 사이에서 이상한 소문이 돌기 시작했다. “DeepSeek 뭔가 달라졌는데?” 아무런 공지도 없이, 기존 128K 컨텍스트 윈도우가 100만 토큰으로 확장되어 있었다. 조용히. 그리고 벤치마크 수치가 하나둘 유출되면서 개발자 커뮤니티가 발칵 뒤집어졌다.

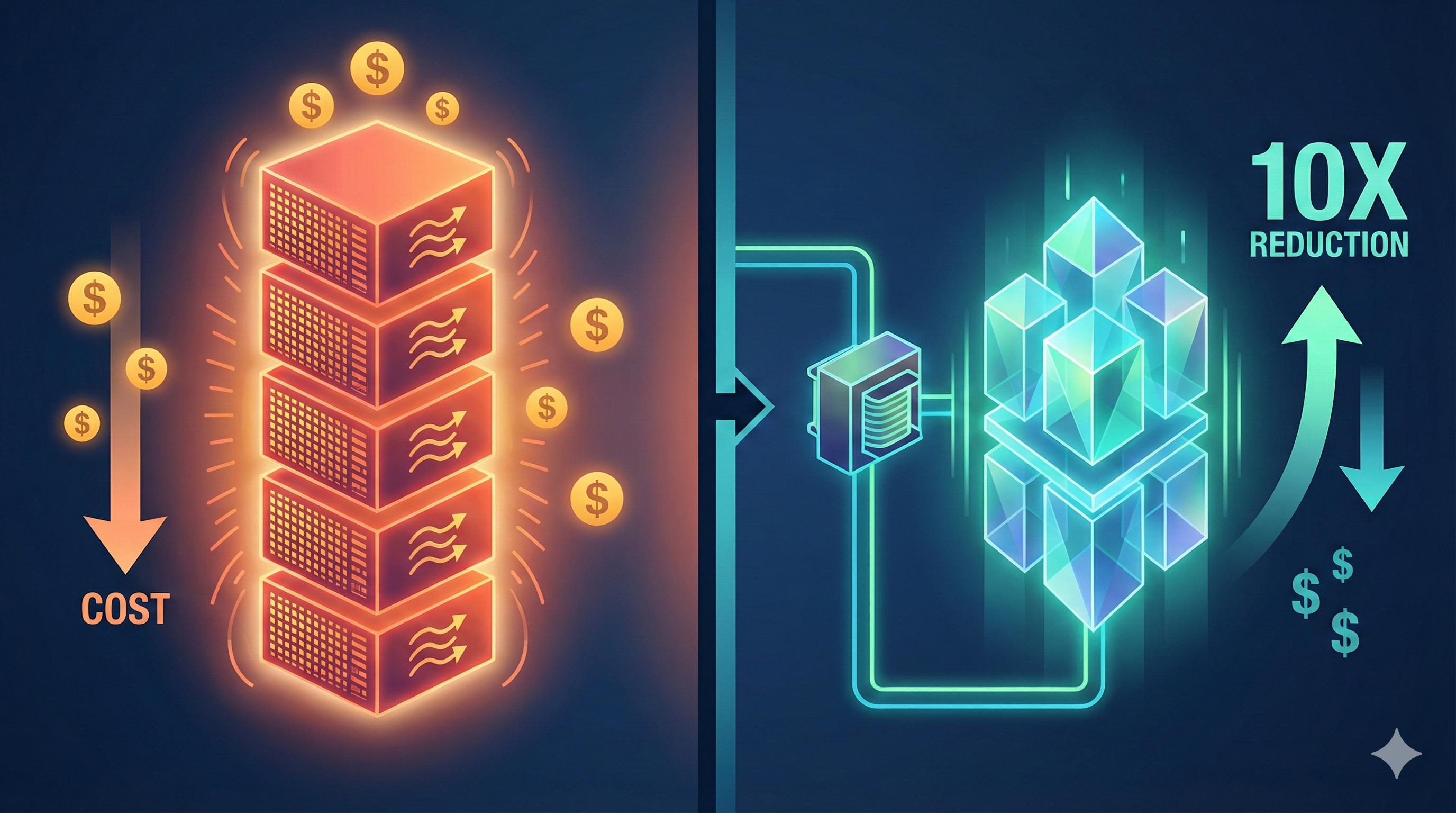

HumanEval 90%, SWE-bench 80% 이상. GPT-4의 82%를 가볍게 넘겼고, Claude Opus 4.5의 80.9%마저 위협하는 수치다. 그런데 진짜 충격은 따로 있다. 가격이 기존 프론티어 모델의 10분의 1이라는 것.

이건 단순한 모델 업데이트가 아니다. AI 코딩 시장의 가격 구조 자체를 뒤흔드는 사건이다.

Engram 아키텍처 — “계산하지 마, 기억해”

DeepSeek V4의 핵심은 Engram 조건부 메모리 시스템이다. 1월 13일 공개된 논문에서 소개된 이 아키텍처는 기존 트랜스포머의 근본적 비효율을 정면으로 겨냥한다.

기존 LLM은 모든 정보를 ‘계산’으로 처리한다. “Python의 print 함수는 어떤 파라미터를 받지?”라는 질문에도 수십억 개 파라미터를 거쳐 연산을 돌린다. 이미 확정된 정적 지식인데도 말이다.

Engram은 이 문제를 O(1) 해시 룩업으로 해결한다:

# 기존 트랜스포머 (모든 것을 연산으로 처리)

def traditional_transformer(query, context):

# 수십 레이어의 어텐션 연산

for layer in self.layers:

context = layer.attention(query, context) # O(n²) 비용

return context

# Engram 방식 (정적 지식은 메모리에서 직접 조회)

def engram_hybrid(query, context):

# 1단계: 정적 패턴은 메모리에서 O(1) 조회

static_result = self.engram_memory.lookup(query)

if static_result.confidence > threshold:

return static_result

# 2단계: 동적 추론만 트랜스포머로 처리

return self.transformer.reason(query, context)

간단히 말하면 “이미 아는 건 외워둔 거 꺼내 쓰고, 진짜 생각해야 할 것만 GPU 돌려라”는 철학이다. Engram 파라미터를 27B로 확장했을 때, 동일 파라미터·동일 FLOP 조건에서 기존 MoE 베이스라인을 추론, 코딩, 수학 전 영역에서 압도했다.

여기에 mHC(Manifold-Constrained Hyperconnection) 기술이 더해져 학습 안정성을 확보했다. 더 큰 모델을 기존 하드웨어 인프라에서 안정적으로 돌릴 수 있다는 뜻이다. 실리콘밸리가 H100 수만 대를 쌓아올릴 때, DeepSeek은 아키텍처 혁신으로 같은 결과를 뽑아낸다.

100만 토큰 — 코드베이스를 통째로 먹인다

개발자로서 진짜 체감되는 변화는 100만 토큰 컨텍스트 윈도우다.

기존 128K 토큰이면 대략 파일 30-40개 정도를 동시에 볼 수 있었다. 100만 토큰이면? 프로젝트 전체다. monorepo의 백엔드, 프론트엔드, 인프라 설정, 테스트 코드까지 한 번에 넣어도 여유가 있다.

# 프로젝트 전체 토큰 수 계산 (예시)

$ find . -name "*.ts" -o -name "*.tsx" | xargs wc -c | tail -1

2,847,392 total # 약 700K 토큰 → V4 컨텍스트 내 충분히 수용

# 기존 모델은 이렇게 쪼개서 넣어야 했다

$ split -b 50000 codebase.txt chunk_ # 컨텍스트 분할의 고통

이걸 가능하게 한 기술이 DeepSeek Sparse Attention이다. 표준 어텐션 메커니즘 대비 연산 비용을 약 50% 절감하면서도 100만 토큰을 처리한다. 컨텍스트 분할로 인한 “파일 A의 함수가 파일 B를 참조하는데, AI가 파일 B를 모르는” 문제가 원천적으로 사라진다.

지금까지 AI 코딩 도구를 쓰면서 가장 짜증났던 순간이 뭐였나 생각해보자. “이 함수의 타입 정의는 다른 파일에 있어”라고 매번 설명해줘야 하는 것. monorepo에서 패키지 간 의존성을 AI가 이해 못 하는 것. V4의 100만 토큰은 이 고통을 원천적으로 제거하겠다는 선언이다.

벤치마크 유출 — 숫자가 말해주는 불편한 진실

2월 초 유출된 내부 벤치마크 수치를 정리했다:

| 벤치마크 | DeepSeek V4 | GPT-4o | Claude Opus 4.5 |

|---|---|---|---|

| HumanEval | 90% | 82% | 88% |

| SWE-bench Verified | 80%+ | — | 80.9% |

| 컨텍스트 윈도우 | 1M+ | 128K | 200K |

| 추정 API 비용 (1M tok) | $0.3 | $2.5 | $15 |

물론 이 수치는 독립 검증 전이라는 점을 분명히 해야 한다. DeepSeek의 자체 벤치마크이고, 실제 출시 후 커뮤니티 검증이 필요하다. V3 때도 초기 벤치마크와 실사용 체감 사이에 괴리가 있었다.

하지만 수치가 절반만 사실이라고 해도 상황이 달라진다. GPT-4급 성능을 10분의 1 가격에, 그것도 오픈웨이트로 로컬 배포까지 가능하다면? 듀얼 RTX 4090이나 RTX 5090 하나면 개인 PC에서 돌릴 수 있다면?

“Claude Opus 쓰는데 월 20만원씩 나가요”라고 하던 개발자들이 “로컬에서 무료로 돌리는데 성능이 비슷한데?”라고 말하기 시작하면, 이건 시장 구조 자체가 바뀌는 것이다.

한 개발자의 반응이 모든 걸 요약한다:

“Claude Opus에서 DeepSeek V4로 갈아탔다. Python 추론 능력은 사실상 동급인데, V4는 로컬에서 무료로 돌릴 수 있다.”

실리콘밸리가 긴장하는 진짜 이유

DeepSeek V4가 무서운 건 성능 때문만이 아니다. 오픈소스 전략 때문이다.

2025년이 DeepSeek에게 분수령이었다. V3와 R1을 연달아 오픈소스로 공개하면서 “수억 달러를 쏟아야만 프론티어 LLM을 만들 수 있다”는 통념을 박살냈다. 실리콘밸리만이 경쟁력 있는 모델을 만들 수 있다는 자부심도 함께.

V4가 오픈웨이트로 풀리면 벌어지는 일들:

1. 가격 경쟁 강제: OpenAI, Anthropic은 프리미엄 가격 전략을 유지하기 어려워진다. “로컬에서 무료로 비슷한 성능 나오는데 왜 API 비용을 내야 하지?”라는 질문에 답해야 한다.

2. 로컬 AI 코딩의 대중화: 기업이 민감한 코드를 외부 API로 보내지 않고도 AI 코딩을 쓸 수 있다. 금융, 의료, 군사 분야에서 “우리 코드를 외부 서버로 보낼 수 없다”는 이유로 AI 도입을 꺼렸던 기업들이 V4의 문을 두드릴 것이다.

3. 스타트업 생태계 변화: “AI 코딩 도구 만들었습니다”라는 스타트업의 진입장벽이 급격히 낮아진다. 오픈웨이트 V4 위에 파인튜닝만 얹으면 되니까.

2025년: "AI 코딩 도구를 만들려면 수십억이 필요합니다"

2026년: "오픈소스 V4 위에 래퍼 씌우면 됩니다"

특히 U-Shaped Scaling Law라는 DeepSeek의 새로운 스케일링 법칙이 주목할 만하다. 메모리 파라미터와 연산 파라미터 사이의 최적 배분을 수학적으로 정의한 것인데, 이건 “무조건 크게 만들면 좋다”는 기존 접근법에 정면으로 반기를 든 것이다. 더 똑똑한 아키텍처가 더 큰 규모를 이긴다는 것을 V4가 증명하려 한다.

마치며

솔직히 말하면, 벤치마크 숫자를 100% 신뢰하긴 이르다. DeepSeek의 발표와 실제 체감 사이에 간극이 있을 수 있고, 실전에서는 파인 튜닝 생태계, 디버깅 편의성, IDE 통합 같은 요소가 성능 수치만큼 중요하다. V3의 한국어 성능이 영어에 비해 아쉬웠던 전례도 있다.

하지만 한 가지는 확실하다. AI 코딩 도구의 가격 전쟁이 본격적으로 시작됐다는 것.

DeepSeek V4가 약속한 성능의 70%만 달성해도, “비싼 API 비용을 내면서 GPT-4를 쓸 이유가 있는가?”라는 질문을 피할 수 없게 된다. 마이크로소프트 코드의 30%, 구글 코드의 25%를 AI가 쓰는 시대에, 그 AI의 가격이 10분의 1로 떨어진다면 선택지는 명확하다.

2월 17일, 구정 연휴에 맞춘 정식 출시 예정. 직접 돌려보고 나서 후속 리뷰를 쓰겠다. 그때까지 한 가지만 기억하자.

이번에는 중국 AI를 무시하면 진짜 뒤처진다.